API流量与爬虫管理:Akamai企业安全两大最新关注点

定位在 “提供安全数字化体验” 的Akamai(阿卡迈),对安全的重视度一直颇高。基于其在全球分布广泛的分发平台而提供的DDoS缓解服务,以及作为Web应用防火墙(WAF)的领先厂商,这是Akamai之前在网络安全领域最令人印象深刻的两个能力。

今年4月,Akamai企业安全“新”技术峰会在北京召开,内容覆盖隐私保护、打击黑产等热点议题,以及Akamai和其客户的安全实践分享。安全牛记者也参加了此次会议。这篇文章主要介绍Akamai近一年安全领域两个最新的关注点:API流量的安全,以及由撞库攻击延伸的爬虫管理。

基于每日分发超过50TB/秒的Web流量的安全洞见

Akamai连续发布《互联网发展状况安全报告》已有多年。基于每日分发超过50 TB/秒的Web流量,在互联网,特别是安全领域,提供分析与洞见。该系列报告包含宏观态势,对Akamai自身的优势积累,如上文提到的DDoS、Web应用攻击等,以及当年Akamai的关注重点,做深度探讨的专题报告。

在《2018年互联网安全状况报告:撞库攻击》中,报告认为,攻击的影响力是重要衡量指标。以DDoS为例,高影响力的攻击,往往通过相同流量就可以给企业带来更多的损害。而高影响力的攻击通常是 “低调缓慢” 的。虽然这种类型的攻击持续时间不如高带宽攻击那么长,但其瞄准的是资源管理的疏漏。可以被纠正,但却经常因维护不善成为长期的 “活靶”。

撞库攻击,也有和DDoS攻击类似的演进思路。口令作为Web应用最大的漏洞,经常结合僵尸网络进行撞库尝试。据Akamai的观察,虽然传统的撞库在尝试失败时会出现明显的峰值,但许多攻击模式已经改变为 “低调缓慢” 的尝试,比如在多个目标之间分散其流量、在扫描中使用大量系统或者随着时间的推移将流量分散等手段,以规避基于速率的检测。但同时,撞库攻击的总量并没有降低,而且针对的行业更加广泛。

Akamai在《互联网安全状况报告:撞库:攻击与经济——特别媒体报告》中提及,在2018年观测到了近300亿次撞库攻击尝试中,不仅包括传统的金融、零售行业,视频媒体、游戏等娱乐业的攻击也出现明显增长。日峰值,2018年全球有三天超过2.5亿次的尝试。而且这些峰值的出现,与数据泄漏事件的发生有明显的联系。

可以判断,结合僵尸网络和数据泄漏的撞库攻击,已成为网络罪犯喜爱的手段。同时,更多行业的账户价值,受到了攻击者的认可。企业面对 “数据泄漏和撞库” 的组合拳时,势必将面临更高的运营成本和防护难度。

目标行业更广泛的撞库攻击,更难以检测和防御,是Akamai认为的现今的一个重要威胁趋势。数据泄漏,低成本撞库工具的培训,受入侵账户的二次销售,这已经成为一个黑色产业链。

无论是撞库还是DDoS,其背后的僵尸网络,都可以归纳为bot,都可以看作爬虫程序。如何实现对爬虫的有效管理,即阻止恶意爬虫,同时允许访客和良性爬虫的访问,是应对和核心思路。

爬虫管理的重点不在封堵

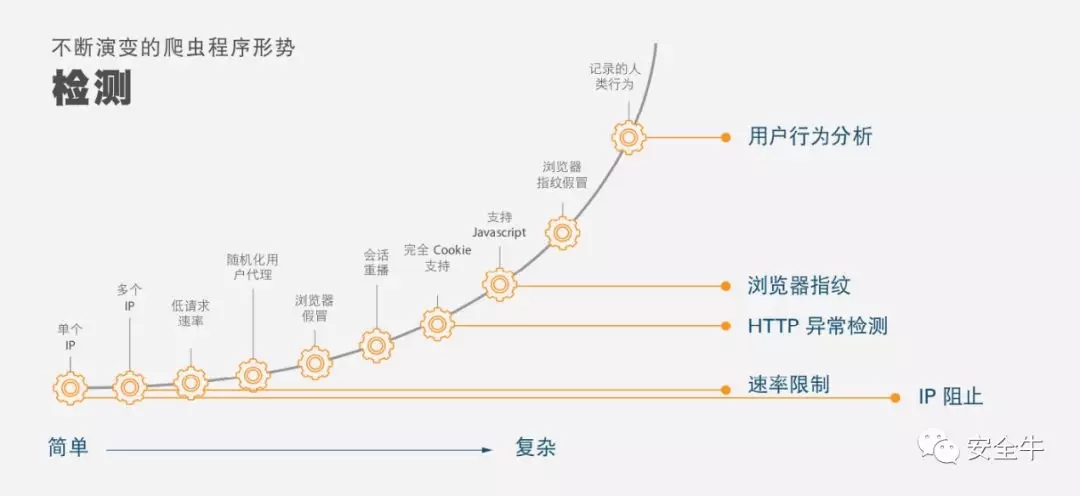

对爬虫管理的思路,和抗D也是类似。一开始都是对IP、对请求速率的限制,但这种思路,相对经验丰富攻击者而言就显得过于单纯。

据Akamai介绍,爬虫管理的首先任务是要区别爬虫和自然人访问行为。技术层面,这需要对大流量进行分析监测,以及深度的可见性。这同时需要足够的数据支撑。而这也正是Akamai的天然优势。

当然,可供参考的评价维度有很多,比如键盘的输入节奏、鼠标轨迹、ip信誉评分、浏览器指纹、http异常等。同时,因为流量巨大,所以兼顾性能,这无疑需要强大的自动化能力做支撑。这部分能力得益于Akamai在全球广泛分布的智能平台对爬虫活动的可见性,以及云安全智能大数据分析引擎(CSI)的分析能力。

Akamai的爬虫管理器(Bot Manager)可以识别1400余种已知爬虫程序,对未知爬虫活动的检测,以及业务导向的爬虫管理策略。

Akamai在Forrester 2018年Q3的New Wave中处于领导者象限

识别、区分之后要做什么?直接阻断么?对于爬虫管理的第二个阶段,Akamai认为,在决定怎样做之前,要先明确爬虫对业务体验以及资源的影响。如果只是简单粗暴的阻断,一种爬虫的失败,会促使攻击者进化,思考更多绕过检测的方式。企业可以根据爬虫的交互方式,以及爬虫流量状态,制定不同的管理策略。这意味着很多的响应方式,如提供虚假的替换内容、延迟提供、告警等。

当然,如果能确认是撞库行为,应坚定的选择阻断。

此外,Akamai在今年1月,宣布正式完成对IAM(身份访问管理)厂商Janrain的收购。通过和Janrain身份云的集成,Akamai希望在爬虫管理和威胁情报两个领域提供更多的实时安全优势,特别是在数据泄漏发生后。

Janrain一直专注于在认证和授权阶段,提供更多的数字信任。就爬虫管理而言,有了Janrain的助力,在用户登陆和注册阶段可以减少用户凭证滥用的风险,并基于过去的线上行为,对欺诈行为做出更准确的判断。

对于爬虫管理的这一市场,Akamai的全球高层也是持乐观态度,认为这是会快速增长的领域。结合Akamai的云防护方案,Akamai可以将防护边界延伸到到离攻击者更近的地方。未来,边缘设备将承载着更多能力和带宽,安全策略的执行也会向外延伸。

API安全实践

除了撞库攻击外,Akamai强调还有一个较新的风险点不容忽视,那就是因为API流量激增,因所带来的安全风险。

API流量,即没有人类直接参与的数据交互,已经达到传统html流量的数倍。据Akamai统计,在Akamai用于银行和零售业的安全交易的安全内容交付网络中(ESSL),html流量的占比,已经从2014年的54%,下降到2018年的17%。而其中,特别是来自应用的json流量快速增长,从2014年的26%,增长到2018年的69%,超过html流量的的4倍。而这其中,真正是由浏览器发起的API调用仅为27%。剩下的API调用,至少有66%可能来自智能手机、应用程序、以及诸如游戏主机智能电视等嵌入式设备。

开发者对API的依赖,无外乎调用灵活,以及对传输时延的考量。特别是视频媒体、以及高科技行业(例如物联网应用),尤其突出。同时,安全风险也很突出——因为虽然与传统的Web有同样的威胁向量,但目前针对API的安全意识和措施却有明显缺失。

可以说,API简单、开放的特性,对攻击者也同样适用。

Akamai在会议现场介绍了一个受API安全影响的实例:

相对独立的内容所有者通常对应多个媒体合作伙伴。经过合作伙伴站点的身份认证后,内容所有者再根据其权限控制内容的分发。攻击者使用僵尸网络,在同一时间,通过某一合作伙伴站点的API向内容所有者发起视频流请求,并在代码中夹杂了大量随机产生的参数,并增加了代码的嵌套层数,逼迫内容分发者在检测时耗费了大量的资源,进而发生服务中断,对其它合作伙伴也无法正常提供服务(因为是一个API支持多个微服务)。

不难看出,没有在API层面做代码和嵌套深度的检查和限制,没有爬虫的管理能力,攻击者可能通过一个合作伙伴影响一整个业务生态的服务能力。从攻击实现角度来看,利用开发者在API接口的疏漏,也更为简单有效。

甚至撞库亦是如此。据Akamai统计,利用API的撞库攻击时传统Web表单的4倍,而且成功率更高。

从防护角度,Akamai给出的建议是,先评估自身的API生态有哪些风险(调用方式,是否有身份认证,代码检测,响应是否含敏感数据等),再定义适当的安全措施。当然,这个过程中,要努力获得高层支持,以推进主动的API保护。

Akamai给出的常见API攻击手段和防护建议:

常见Web攻击(SQL注入、CSS、命令行注入等):WAF规则

反序列化攻击:API白名单

应用逻辑攻击:参数验证

信息泄漏:HTTP请求方式白名单

逻辑DoS攻击:参数和深度限制

低速率攻击:低速率POST保护

7层DDoS攻击:速率控制